AI工具为什么会被谷歌算法打击呢?Glarity工具案例

Glarity这款工具我年初使用过一段时间,其主要的作用就是利用AI帮我们总结油管视频的大纲,从而方便我们知道这个视频中描述的是什么内容。最近偶然间发现这款工具的流量暴跌,那这篇文章就简单从内容策略上聊聊原因。

从上图可以看到,这款工具站点的流量从四月份的400万暴跌到六月份的20万,到现在估计大几万的水平了。可以说经过三月份的算法更新,整个站已经不复往日的辉煌了。

至于为什么会被算法打击,就不得不提及这款工具站点的内容策略。

通过搜索命令查询,可以看到这个站点目前仍有10万条收录(站点有40多种小语种)。可能巅峰期的收录数量会更多,但这里我暂时就不去深度挖掘了。

所以从这个数据出发,站点的英文内容应该在2500条左右。但是你现在仔细去看这个站点,无论是在页面上正常浏览,还是去观察站点地图,基本都发现不了这2500条内容在哪里(后面发现是因为站点被打击所有AI内容全部下架)。

于是就花了点功夫去看站点的历史版本,随便找了几篇英文内容去认真读了一下。

发现这些内容的AI痕迹很明显,基本都是AI生成的一些文案,这也就解释了网站为什么会有如此多的收录(他们将那些生成的视频内容摘要放到自己的网站上当做自己的内容了)。

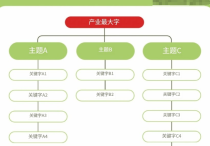

那这个网站的内容生产的逻辑大致就清晰了。

首先,网站提供的那个插件工具可以帮助用户总结油管视频的内容摘要。但是在生成内容摘要时,网站会将那些摘要信息全部保存下来,并上传到自己的网站上请求谷歌搜索引擎的收录。

在这个过程中,插件使用得越频繁,AI摘要信息生成的越多,那网站的内容自然也就越多了。是不是有点「一石二鸟」的感觉,利用用户在插件使用过程中的生成的信息直接做成内容,不仅节省人力成本,而且还节省token消耗。

但这个插件工具怎么处理重复内容的逻辑,我现在没怎么搞明白。可能在代码逻辑上有去重机制吧,这些已经不重要了。

可能这一套「AI内容农场」的玩法,在年初之前都是有效的,毕竟这个站点的流量高峰到达过千万级别。但是经过三月份的那次历史级别的算法更新,一切就都俱往矣了。

所以从这个工具站案例,就能发现「AI内容农场」这一套玩法已经行不通了。

但即便如此,在工作过程中还是会发现很多很多这样的案例,直接将AI生成的内容上传到网站请求收录,美其名曰使用了高级版本的模型,内容更接地气。

没办法,好良言难劝该死的鬼。